Mimoza Xharo (Duka)*

Teknologjitë e reja kompjuterike dhe sidomos Inteligjenca Artificiale duket se do të rikonturojnë një mënyrë tjetër sjellje për individët, korporatat, apo edhe duke adaptuar apo krijuar ndryshime të thella. Mjaft studiues i krahasojnë këto zhvillime me revolucionin industrial (1760-1840), që shënoi periudhën e kalimit nga puna manuale në atë të makinerive, aq sa edhe Inteligjencën Artificiale (AI) po e njohin si revolucioni 4.0, apo një zhvendosje të thellë drejt ‘softe-ve’.

Ashtu si revolucioni industrial u pa fillimisht me ankth e skepticizëm për kaosin e vendeve të punës, ndërkohë që solli prodhim, zhvillim të vrullshëm ekonomik, edhe ‘revolucioni 4.0-AI’ besohet për evolucion, dinamizëm, ndryshe një transformim të thellë në historinë njerëzore.

Debatet më të fundit publike, por edhe nga më të larmishmet të fokusuara tek Inteligjenca Artificiale (IA), shoqërohen me entuziazmin që do sjellin jo vetëm për teknologjitë e informacionit.

AI priret në avantazhe të panjohura më parë, që lidhen jo vetëm me shpejtësinë e ofrimit të një shërbimi, por edhe te performimi i funksioneve shumë më komplekse, mundësimin e një vendimmarrje më të shpejtë, inovacione në fushën e ekonomisë, tregun e punës, arsimimin dhe kurrikulat e tij.

Debati ngrihet në faktin nëse AI do të zbehë funksionalitetin e sistemeve ekzistuese, do të kërkojë e krijojë një gjeneratë të re punonjësish e ndoshta të zëvendësojë një sërë profesionesh, por duke mundësuar shumë më shumë të reja.

Debati, tashmë ka përfshirë edhe kontekstin e sigurisë, veçanërisht për agjencitë e zbatimit të ligjit, të inteligjencës duke krijuar mundësinë e përpunimit të një sasie më të madhe të informacionit në kohë më të shpejtë, me idenë për të parandaluar dhe neutralizuar në kohë ngjarje nga aktivitete të jashtëligjshme deri në krime të rënda. Dilema hidhet nëse ‘loja’ do të zhvillohet në një ambient më konkurrues, varësisht nga aksesi, përdorimi i softeve dhe synimi i përdoruesve, apo do të kërkojë e krijojë një ambient të ri të panjohur më parë. Koha krijon sa aleancë po aq edhe sfidë.

Në këtë paradigmë me avantazhe e sfida, ekspertët, analistët dhe studiuesit e fushës së sigurisë po fokusohen, në atë që konsiderohet, në terma akademikë si sigurizimi i inteligjencës artificiale, pra siguria e përdorimit të programeve të inteligjencës artificiale. Impakti që do të afektojnë dinamikën tonë, për ta përdorur IA si avantazh të qenësishëm vlerësohet se do të varet më së shumti nga mënyra se si do trajtohen principet e sigurisë, etikës, respektimin i të drejtave themelore humane e deri në pronësinë intelektuale.

Në këtë kontekst vlerësohet se pjesa më kritike do të mbetet aftësia për të mbrojtur të dhënat, algoritmet, më thjeshtë ‘softet’ me të cilat operojnë programet e inteligjencës artificiale. Pra ndjehet dukshëm nevoja për të sigurizuar vetë inteligjencën artificiale.

Debatet dhe shqetësimet për impaktin në çështjet e sigurizimit të inteligjencës artificiale.

Me daljen e programit ChatGPT dhe modelet shumëgjuhëshe ML, përveç avantazheve dhe evolucionit të vrullshëm që sjellin, çështja e sigurizimit të IA po merr një vend të rëndësishëm në debatin e ekspertëve të sigurisë ndërkombëtare, posaçërisht të asaj kibernetike si një proces dukshëm i vështirë ku aktualisht evidentohen barriera:

1. Kodi që mundëson Inteligjencën Artificiale paraqet dobësi si çdo kod në sistemet online. Për vite me radhë kemi parë se si hakerat janë të aftë të shfrytëzojnë dobësitë për të arritur synimet e tyre, çka risjell në vëmendje çështjen e masave të sigurisë mbrojtëse, pasi këto programe janë dizenjuar të prodhojnë pasi kanë dixhestuar sasi të konsiderueshme informacioni;

2. ‘Helmimi’ i të dhënave ose ndryshe manipulimi i tyre nga hakerat jo-shtetërorë dhe shtetërorë për synime kriminale deri për synime gjeopolitike duke afruar burime informacioni që shfrytëzojnë programet të manipuluara apo të servirura qëllimisht.

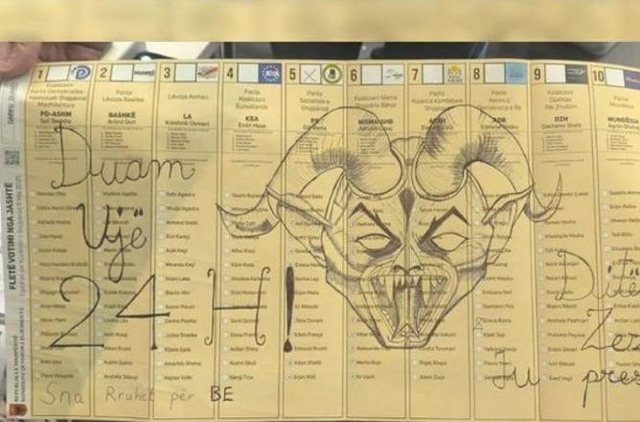

Programet e bazuara në IA mundësojnë krijimin e një larmie produktesh: video fallco, lajmeve të rreme dhe forma të tjera manipulimi dixhital, të cilat përhapin dizinformacion dhe influencojnë publikun përkundrejt synimeve. Tashmë kjo prej ekspertët të sigurisë njihet me termin teknologjitë e reja çorientuese, që zhvillohen kryesisht nga aktorët shtetërorë autoritarë për synime gjeopolitike.

3. Gabimet e pavullnetshme njerëzore të cilat mund të sjellin pasoja. Në një botë kur vendimet merren dhe zbatohen në kohë të shpejtë , impakti i sulmeve apo algoritmeve të gabuara mund të sjellin pasoja të pallogaritshme. Një rast që përmendet p.sh. në studimet e sigurisë kibernetike, është historia e kompanisë së mirëmbajtjes së softeve Knight Capital, e cila humbi 440 milion dollarë në 30 minuta për shkak të një gabimi në algoritmin e kompanisë. Kompania u ndodh në prag të falimentimit apo përthithjes nga rivalët. Në këtë rast nuk bëhej fjalë për veprime të qëllimshme nga kundërshtarët, por mbetet një ilustrim i impaktit potencial të një gabimi në algoritëm, i pavullnetshëm apo i vullnetshëm (i bërë qëllimisht i tillë).

4. Abuzimet me programe bazuar në Inteligjencën Artificiale, lidhen me programe të reja që mund të zhvillohen mund të manipulohen që nga instalimi e përgjatë ciklit. Ngjashëm çdo e dhënë e kompromentuar apo algoritëm mund të rezultojnë në vendimmarrje të gabuara që lidhen me sektorë të rëndësishëm, të përcaktuara si të tilla nga Komisioni Evropian.

5. Rreziku i programeve të reja nga shtetet autoritare kundërshtare të sistemit demokratik, me synim aktivitete influencuese malinje dhe hibride për synime gjeopolitike dhe gjeoekonomike. Aktorët kërcënues mund të zhvillojnë aplikacione të dëmshme, të krijojnë përmbajtje keqinformuese, dezinformuese. Sipas Raportit të Agjencisë Europiane për Siguri Kibernetike ENISA, ku paraqitet një vlerësim i kërcënimeve që gjenerojnë ndaj sigurisë kibernetike deri në vitin 2030, p.sh. një aktor shtetëror autoritar synon të vendosë publikun kundër vendimmarrjeve të rëndësishme dhe të përpiqet të manipulojë të dhënat e algoritmeve të një agjencie zbatimi ligji apo entiteti shtetëror, për të targetuar një publik, një shtet, e shkaktuar destabilitet.

6. Respektimi i pavarësisë së të dhënave personale, si një nga çështjet më shqetësuese për publikun e thjeshtë. Përsa kohë IA grumbullon, proceson një gamë të gjerë të dhënash, ekziston rreziku që ky informacion të keqpërdoret qoftë vullnetarisht kur ka synim qoftë në mënyrë të pavullnetshme apo rrjedhje aksidentale;

7. Mungesa e mbikëqyrjes njerëzore për shkak të autonomisë së programeve, pasi sa më shumë autonome të jenë programet aq rritet edhe kërcënimi kibernetik ndaj tyre. Të gjitha sistemet/programet e inteligjencës artificiale mund të operojnë automatikisht, çka mund të rezultojë në mungesën e mbikëqyrjes njerëzore mbi to;

8. Problematika që lidhen me etikën. Nëse të dhënat që procesohen nga programet e IA janë të komprometuara edhe konkluzionet do jenë të tilla. Kjo mund të rezultojë në trajtim diskriminues p.sh. ndaj individëve, grupeve racore, etnike, sociale , duke thelluar problematikat ekzistuese mes tyre;

9. Krijimi i konfuzionit, sidomos në sistemin arsimor, kontradikta mes informacionit të vërtetë shkencor dhe atij që serviret nga programet, varësisht nga zhvilluesi dhe përdoruesi i programit dhe nga të dhënat që programohen të shfrytëzohen më pas automatikisht;

10. Implementimi gjithashtu i një programi, mund të jetë i kushtueshëm, kryesisht për bizneset e vogla deri të mesme, të cilat mund të mos kenë burime për investime të kësaj teknologjie. Kjo do rrisë dhe rikonfigurojë konkurrencën por gjithashtu mund të nxisë bizneset në nevojë apo individët të përdorin programe të zhvilluara nga shtete autoritare, me çmime më të ulëta nga ato që ofrohen nga kompanitë perëndimore;

11. Problematika lidhur me aksesin për motive sigurie, pasi programet që mund të zhvillohen mund të mbeten jashtë bashkëpunimit me kompanitë zhvilluese të tyre, që mund të jenë të sponsorizuara nga shtetet kundërshtare autoritare, e ilustruar më së miri me rrjetet sociale, ku mes tyre ka të tilla, ku zotëruesit nuk i nënshtrohen rregullave ndërkombëtare dhe nuk njohin detyrimin për të bashkëpunuar me agjencitë ligj zbatuese të vendeve perëndimore.

Inteligjenca Artificiale është aq e mirë sa edhe të dhënat që shfrytëzon dhe mbetet pa asnjë dyshim e ardhmja e teknologjisë së avancuar. Në këtë kontekst kur flasim për impaktin ndaj sigurisë, nuk mund të ndalojmë progresin, por të ecim paralelisht me të në mënyrë inteligjente, ku bashkë me evoluimin e teknologjive dhe digjitalizimit, siguria e sistemeve mbetet thelbësore. Pa dyshim që dobësitë dhe rreziqet nuk do duhet të mohojnë një shërbim evolucionar, pasi ashtu si një armë e mbushur nuk është e rrezikshme në vetvete, personi që e mban atë në dorë është i rrezikshëm varësisht nga synimi i përdorimit dhe përdoruesit të saj.

Inteligjenca artificiale gjithashtu sado e avancuar të jetë nuk mund të zëvendësojë inteligjencën emocionale njerëzore. Sipas studimeve të fushës, IA, aktualisht mund të detektojë botën emocionale në rreth 80%, nivel i cili varet nga teknologjia, por pa arritur inteligjencën komplekse emocionale njerëzore. Ndërsa IA bazohet në të dhënat dhe algoritmet, inteligjenca emocionale njerëzore EI lidh logjikën me emocionet; IA analizon të dhëna të trajnuara e grumbulluara në kohë të ndryshme, që përshijnë të tashmen dhe të kaluarën, ndërsa EI bazohet në ndjesi emocionale të momentit specifik; AI nuk ndikon në rritjen dhe zhvillimin individual ku vështirësitë e maturojnë individin të aftë për tu përballuar me ato. Sipas Dr. Amit Ray, Inteligjenca Emocionale njerëzore ndërton liderin e fuqive humane, ndërsa Inteligjenca Artificiale ndërton liderin e fuqive të softeve dhe makinerive. Sa më shumë që inteligjenca artificiale hyn në botën tonë aq më shumë inteligjencë emocionale njerëzore duhet të kenë lidershipet.

Si konkluzion, teknologjitë e reja do të sjellin avantazhe të panjohura më parë në historinë e njerëzimit , por edhe kërcënime të reja për nga natyra ku ato kibernetike dhe hibride do jenë më domethënëset dhe prioritaret për t’u adresuar. Përballjet pa dyshim do të bëhen më të sofistikuara dhe me kombinime komplekse ‘on dhe off-line’. Aktivitetet hibride dhe ato influencuese malinje do të njohin rritje. Trajnimi, edukimi mbi mënyrën se si do të funksionojë ky ekosistem i ri teknologjik do të kërkojë me domosdo sigurizimin e inteligjencës artificiale dhe mundësitë janë për të ecur paralelisht për një botë më të sigurt, ashtu siç e ka shprehur edhe Marc Anderssen një dekadë më parë se ‘softwari po ha botën dhe inteligjenca artificiale do hajë softwaret.’

*Mimoza Xharo (Duka) ka fituar PhD në fushën e sigurisë dhe është autore e librit ‘Një Paradigmë e re në Inteligjencë’.